Les méthodes de numérisation 3D terrestre ne se limitent pas à l’emploi de la lasergrammétrie déclinée dans différents modules LiDAR fixes ou mobiles.

Mais n’oublions pas que la photogrammétrie fait également des merveilles ! Pour rappel, il est ici question de reconstruire un modèle tridimensionnel sur la base de photographies d’une même scène, prises avec un angle de vue différent. La diversité des points de vue permet de reproduire informatiquement le principe de la vision stéréoscopique humaine (et animale) qui permet de voir les reliefs et qui, couplée à la mémoire visuelle et à un déplacement dans la scène, permet d’en obtenir une image mentale dans toutes ses dimensions.

[qodef_blockquote text="Selon les conditions de prise de vue, la photogrammétrie est qualifiée d’aérienne ou de terrestre." title_tag="p" width=""]

Ce chapitre instaure les notions de photographie nécessaires aux deux domaines d’application, mais reste focalisé dans un premier temps sur des conditions de prise de vue terrestre.

Le matériel

Procéder au scanning d’une scène par photogrammétrie nécessite quelques connaissances de base en matière de photographie. Bien que chacun d’entre nous soit un utilisateur régulier d’appareils photos et de smartphones, prenons le temps de détailler les notions ayant un impact important lorsqu’on souhaite pratiquer la photogrammétrie.

Lors d’une prise de vue, il est possible d’ajuster 5 paramètres pour contrôler la qualité de la photo :

- la résolution,

- la distance focale,

- l’ouverture de l’objectif,

- la vitesse d’obturation,

- la sensibilité du capteur.

1. La résolution

Cette notion est connue de la grande majorité des utilisateurs et désigne le nombre de pixels capturés par l’appareil à chaque fois qu’une photo est prise.

[qodef_blockquote text="La résolution d’une photographie est une donnée importante mais non suffisante pour influer sur la résolution spatiale d’un modèle photogrammétrique." title_tag="p" width=""]

Ce qui importe lors d’une reconstruction 3D est de maîtriser la précision du modèle final. On ne parle alors plus en nombre de pixels, mais en correspondance entre un pixel et les distances réelles sur site. Une résolution spatiale s’exprime donc sous la forme d’un ratio de type “10cm/pixel” qui signifie pour cet exemple qu’un pixel mesuré sur l’écran correspond à 10cm sur site.

Cette notion de résolution spatiale est banale dans le monde des SIG (Systèmes d’Information Géographique) historiquement basé sur des données 2D, mais devient complexe à évaluer lorsqu’on parle de reconstruction 3D.

Un modèle photogrammétrique est, par définition reconstruit grâce à une diversité de points de vue, donc de distances avec la scène, et de ce fait, à une grande disparité des résolutions spatiales.

Les discours des entreprises reposent fréquemment sur cette ambiguïté pour valoriser des niveaux de précision qui ne sont atteints que très localement, et nullement de manière homogène sur l’ensemble de la capture 3D. Il n’en demeure pas moins que choisir un appareil photo ayant une forte résolution sera primordial pour réaliser des missions de photogrammétrie.

2. La distance focale

Cette valeur est exprimée en millimètres et correspond à la distance entre le capteur et le centre optique de l’objectif.

La longueur focale influe sur le grossissement du sujet à photographier et sur l’angle de vision.

Plus la focale est courte, et plus l’angle de vision est grand.

Les objectifs dits « grand-angle » ont donc une distance focale faible, généralement autour de 16 mm alors que les « téléobjectifs» dépassent allègrement les 400 mm. Lorsqu’on utilise le zoom d’un appareil photo on influe donc sur la distance focale.

[qodef_blockquote text="Pour reconstruire une scène en 3D, l’utilisation de grands angles constitue souvent un gain de temps important." title_tag="p" width=""]

En effet, la vue plus “large” qu’apporte les longueurs focales faibles sur la scène à numériser permet de capter un plus grand nombre de “points clés” nécessaires à la corrélation d’images et à la reconstruction d’un nuage de points. Notez toutefois que l’utilisation d’objectifs grand-angle réduit considérablement la résolution spatiale potentielle de la scène car à nombre de pixels équivalent, un appareil grand angle verra une scène plus large, chaque pixel correspondant donc à une distance physique plus grande.

Il conviendra donc de jouer sur les différents niveaux de zoom ou de se rapprocher des objets pour améliorer la précision des zones le nécessitant.

3. L’ouverture

Le diaphragme d’un appareil photo est une sorte de bague mécanique dont le diamètre varie pour influer sur la quantité de lumière pénétrant dans le capteur.

Quand on parle d’ouverture, on parle de l’ouverture du diaphragme. Le choix de l’ouverture a une incidence directe sur la “profondeur de champ”, notion désignant le segment en profondeur de l’image sur laquelle la netteté sera acceptable. Une grande ouverture (f/2.8) provoque une faible profondeur de champ et donc un flou très prononcé de l’arrière plan.

Cet effet dit “de focus”, également nommé bokeh, présente des intérêts pour les photographes professionnels qui peuvent ainsi réaliser de sublimes portraits mais qui est totalement contre-productif lorsqu’on parle de photogrammétrie, pour laquelle nous avons besoin d’un maximum de précision y compris à l’arrière-plan des photographies.

[qodef_blockquote text="Il sera donc préférable de privilégier une petite ouverture qui crée une grande profondeur de champ et améliore la précision de l’arrière-plan." title_tag="p" width=""]

La difficulté réside dans le fait que la réduction de l’ouverture du diaphragme diminue également la quantité de lumière reçue par le capteur. En cas de scène sombre, les deux seuls moyens de maintenir une faible distance focale seront d’allonger le temps de pose en réduisant la vitesse d’obturation, ou bien d’utiliser une sensibilité ISO supérieure.

4. La vitesse d’obturation

Le boîtier d’un appareil photo contient un obturateur. Il s’agit d’un mécanisme à rideaux qui recouvre le capteur lorsqu’il est au repos.

Ce rideau s’ouvre à une vitesse variable de manière à exposer plus ou moins longtemps le capteur à la lumière.

[qodef_blockquote text="Plus la vitesse d’obturation est rapide, et moins le capteur reçoit de lumière." title_tag="p" width=""]

Le temps d’ouverture est exprimé en fraction de secondes (1/500 ou 1/10 par exemple).

En augmentant le temps d’ouverture on offre la possibilité au capteur de recevoir une plus grande quantité cumulée de lumière, améliorant ainsi la luminosité et compensant ainsi par exemple l’emploi d’une distance focale faible.

Toutefois, l’utilisation de temps de pose plus long augmente le risque d’aboutir à des photos floues en raison des potentiels mouvements induits à l’appareil photo lors de la prise de vue. Si cela peut être compensé par les stabilisateurs optiques dans une certaine mesure, les stabilisateurs numériques ne sont pas recommandés du fait de la modification algorithmique des pixels de l’image employée pour corriger la netteté.

La meilleure parade reste bien évidemment l’emploi d’un trépied. Si, pour diverses raisons, la vitesse d’obturation ne peut être une variable d’ajustement, il reste toujours la possibilité d'intervenir sur la sensibilité ISO.

5. La sensibilité ISO

La sensibilité ISO désigne la capacité du boitier à être sensible à la lumière. Chaque capteur a une sensibilité de base qu’il est possible d’augmenter pour compenser un manque de lumière, Ainsi, le signal lumineux est amplifié par un circuit électronique afin d'accroître la luminosité des pixels. S’agissant d’une correction électronique, un “bruit” important, parfois nommé “grain”, apparaît alors sur les images.

Ces pixels aberrants peuvent apporter un cachet particulier au travail d’un photographe mais constituent une véritable problématique pour les travaux de photogrammétrie qui s’appuient justement sur la cohérence visuelle des pixels pour procéder à des corrélations d’images.

Si, en théorie, le choix de la sensibilité ISO permet certains compromis entre vitesse, ouverture et focale, l’idéal restera d’utiliser la sensibilité ISO la plus faible possible pour obtenir une meilleure qualité d’image.

N'écoutez pas les autres !

Connaître le fonctionnement intrinsèque des appareils photo permet dans un premier temps d’acheter un matériel adéquat. En effet, se fier aux avis des clients et aux tests menés par des professionnels ne sera malheureusement que très peu utile et pourra même conduire aux pires des choix.

Prenons l’exemple de la profondeur de champ.

Un appareil photo ayant une ouverture constante de f/2.8 quelque soit le niveau de zoom aura donc une profondeur de champ très faible même en mode téléobjectif. Cette particularité présente uniquement sur certains appareils photos est fortement appréciée des utilisateurs car elle permet de faire de sublimes portraits même en zoomant, le visage sur lequel la mise au point est faite se détachant fortement de l’arrière-plan flou.

[qodef_blockquote text="Ce type de matériel a toutes les chances d’être bien évalué par le grand public mais sera pourtant très mauvais en photogrammétrie." title_tag="p" width=""]

Ce travail de reconstruction nécessite un maximum de netteté en tous points de la photo afin d’améliorer la corrélation d’images et la résolution spatiale finale.

Bien que très techniques et difficilement mémorisables, ces informations relatives au fonctionnement des boitiers photo devront être évaluées avec justesse lors de l’achat.

Workflow d’acquisition

Au delà du choix du capteur, la procédure d'acquisition a également une importance capitale pour maximiser la qualité du modèle photogrammétrique et devra donc respecter certaines étapes.

Préparez la scène

Souvenez-vous que la photogrammétrie ne peut pas fonctionner dans certaines conditions telles que sur des surfaces transparentes ou réfléchissantes, dans des conditions climatiques défavorables ou avec un éclairage inadapté. La première étape consistera donc à optimiser les conditions de prise de vue.

Pour une scène en extérieur, si vous avez une certaine souplesse sur la date de prise de vue, privilégiez les jours sans pluie et “sans ombres”, que les photographes qualifient généralement de “jours blancs”, produits par la présence dans le ciel d’un voile d’altitude ayant tendance à diffuser la lumière.

[qodef_blockquote text="Ne cédez pas à la tentation de préférer des jours de plein soleil, le contraste entre zones exposées et zones ombrées risquerait d’être trop fort et de conduire à une perte d’informations sur les pixels concernés. " title_tag="p" width=""]

Si votre scène comporte des surfaces transparentes ou réfléchissantes, tant que possible masquez les en les couvrant ou les opacifiant. Il existe dans le commerce des aérosols dédiés à cet usage. Afin de permettre le recalage du modèle à une échelle réaliste et dans un système de projection connu, le placement de cibles sur la scène est également nécessaire.

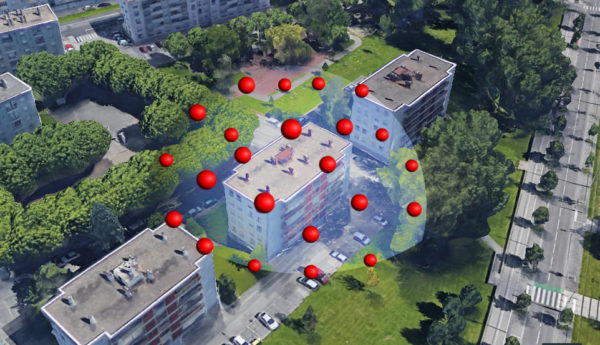

Réfléchissez aux différents points de vue

La photogrammétrie 100% terrestre atteindra vite ses limites en la matière. En effet, rappelons que cette méthode de numérisation 3D requiert une diversité maximale de points de vue couvrant de manière totale et homogène la scène à capturer. Or, prendre des photos des parties les plus hautes d’un bâtiment par exemple ne sera pas toujours chose aisée.

En milieu urbain, l’accès aux étages ou aux toits des immeubles avoisinants pourra être une solution pour obtenir des vues plongeantes sur la scène, mais cette configuration ne sera souvent pas possible pour des scènes plus isolées. L’utilisation d’un escabeau ou d’une perche télescopique pourra dépanner, mais ne sera jamais pleinement satisfaisante pour obtenir des photographies de qualités en nombre suffisant.

[qodef_blockquote text="Les solutions aéroportées telles que les drones s'avèrent donc souvent indispensables." title_tag="p" width=""]

En admettant que votre scène puisse être capturée intégralement depuis le sol, considérez-la toujours comme un objet qui aurait été placé sous cloche.

Votre rôle est de vous promener en tous points sur cette cloche et de prendre des photos !

Ce raisonnement est valable pour la plupart des configurations de type outdoor, mais ne saurait suffire pour scanner l’intérieur d’un bâtiment. L’objectif dans un tel cas de figure reste de minimiser les zones occluses, mais la méthode ne saurait être la même, et il conviendra alors de longer les murs en prenant en photo la scène sous différents angles et à différentes hauteurs.

Attention! Lors de vos déplacements, veillez à ne pas modifier l’aspect de la scène.

[qodef_blockquote text="Ne bougez donc pas les portes ! Ouvrez-les à votre arrivée et veillez à les maintenir dans cette position tout au long de la prise de vue." title_tag="p" width=""]

Un objet ayant été déplacé sera toujours utilisé pour procéder à la corrélation informatique des images, mais produira alors des erreurs d'interprétation conduisant à une dégradation du modèle 3D voire à l’incapacité de reconstruire la scène dans certains cas extrêmes.

Prenez les photos

Maintenant que vous avez retenu leurs positions idéales, les prises de vue peuvent être réalisées. Veillez à régler votre appareil photo au préalable afin d’optimiser les différents paramètres. Si plusieurs appareils sont utilisés, pensez à les configurer de la même manière, notamment en ce qui concerne la colorimétrie.

Définir une balance des blancs commune aux différents matériels, mais également constante tout au long de l’arpentage, permettra d'homogénéiser la colorimétrie des meshs et nuages de points générés au terme de la photogrammétrie, ce qui peut avoir une importance capitale pour certaines applications notamment liées à la préservation du patrimoine.

Veillez toujours à maximiser la netteté de vos images en utilisant un appareil avec stabilisation optique, posé sur trépied, ayant la plus grande profondeur de champ possible. La résolution du capteur influe directement sur la résolution spatiale du modèle 3D, utilisez donc le format d’image captant le plus grand nombre de points.

Une notion importante est le “recouvrement” entre les différentes photographies, notion désignant la proportion commune entre deux images. Généralement employé lors de la construction d’images panoramiques provenant d’un appareil photo ayant été pivoté sur son axe, le recouvrement sera souvent complexe à évaluer dans une démarche photogrammétrique puisque l'appareil photo change totalement de position. Lorsque cette notion ne sera difficilement quantifiable raisonnez plutôt en termes de “points clés” sur vos images, tels que des objets très facilement reconnaissables, l’objectif étant d’avoir toujours le plus grand nombre de points clés en commun entre vos différentes photos. Pensez à analyser à la fois le premier plan mais également l’arrière-plan.

Concernant le nombre de photos, il n’est pas possible de définir une règle générale car il dépend directement de la configuration de l’ouvrage à numériser, de son étendue, de son éventuel encombrement qui peut générer de nombreuses zones occluses, mais également du niveau de détails attendu pour le modèle 3D. Sachez qu’une mission photogrammétrique se compte généralement en plusieurs centaines pour les plus petites et peuvent atteindre plusieurs dizaines de milliers de photographies.

Traitement photogrammétrique

Au terme de la prise de vue, les photos doivent être traitées par un logiciel de photogrammétrie installé sur un ordinateur ou un serveur de calcul. Ne tardons pas avant d’insister sur ce point, les performances matérielles nécessaires à une reconstruction 3D par corrélation d’images sont très élevées et il ne sera pas envisageable de vous lancer dans ce genre d’opérations sur un ordinateur de milieu de gamme. Les composants principalement mis à l’épreuve sont le processeur, la mémoire vive et la carte graphique selon les différentes phases de la reconstruction 3D.

Etape 1

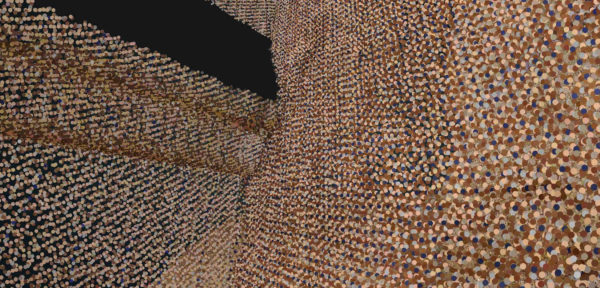

Dans un premier temps, les logiciels procèdent à la détection de points clés dans les images, facilement reconnaissables par leur singularité. Le processeur (CPU) est alors fortement sollicité pour détecter ces points clés dans l’ensemble des images puis, en se basant sur les phénomènes de parallaxe, pour retrouver l’origine de chaque photo, c’est-à-dire la position de l’appareil lorsque la photo a été prise. Au terme de cette première étape, la scène commence d’ores et déjà à être modélisée en 3D : les photos sont toutes associées à une origine définie X, Y et Z, et les points clés forment un premier “nuage de points” de faible densité servant de squelette au modèle 3D.

Etape 2

La seconde étape continue de solliciter le processeur mais demande également beaucoup de mémoire vive.

A ce stade, le nuage de points est densifié par le logiciel de photogrammétrie qui va opérer une seconde phase de traitement. Chaque image étant associée à une origine, le principe de stéréoscopie peut s’appliquer plus aisément qu’en cherchant à assembler des images sans avoir la moindre idée de leur position. Les corrélations ne sont plus cherchées à l’aveugle.

Les pixels les moins atypiques ont déjà une position approximative supposée qui, en raison de la position attribuée à chaque photographie, restreint la zone de recherche de points communs images. Beaucoup plus de pixels de la scène sont désormais ajoutés au nuage de points, nécessitant donc une quantité de mémoire vive conséquente.

Au terme de la seconde étape, le nuage est qualifié de “dense”. Il contient le nombre maximal de points qu’il sera possible d’atteindre pour la scène concernée. La plupart des logiciels permettent de définir la profondeur de calcul afin d’influer sur cette valeur, et tous les logiciels n'aboutissent pas à la même densité de points. Les outils évoluent très vite et selon les types d’ouvrages à numériser, les résultats peuvent être assez variables d’un logiciel à l’autre, il est donc vivement recommandé d’opérer vos propres tests.

Etape 3

Dans un troisième temps, le nuage de points est colorisé. Chaque point prend la couleur moyenne constatée sur l’ensemble des photos ayant servi à son positionnement dans l’espace. Si cela rend le modèle 3D bien plus compréhensible, le niveau de rendu est fortement amélioré par l’étape n°4.

Etape 4

Cette dernière phase consiste en la création d’un mesh. Pour rappel un mesh est un assemblage de faces triangulaires venant recréer une surface tridimensionnelle. Les points du nuage définissent la position des sommets et les triangles sont reconstruits de manière à les rendre les plus équilatéraux possibles, généralement via la méthode de triangulation de Delaunay.

Ce mesh permet d’obtenir une surface sur laquelle “draper” la texture provenant des photographies. Ainsi lorsqu’on regarde un mesh on ne voit pas de vide entre les points mais bien une surface ayant une texture réaliste.

[qodef_blockquote text="En ce sens, un mesh est hautement plus immersif qu’un nuage de points car la visualisation de la scène est bien plus intelligible." title_tag="p" width=""]

A cette étape, le logiciel de photogrammétrie va aller piocher des fragments d’images dans chaque photo pour venir les plaquer sur chacune des faces triangulaires tout en homogénéisant l’apparence globale en moyennant sur les couleurs pouvant varier d’une photo à une autre (en cas de variabilité de la balance des blancs par exemple). Pour ce type d’opérations informatiques, c’est généralement la carte graphique (GPU) qui est la plus sollicitée.

Au terme du traitement photogrammétrique, la scène est totalement reconstruite en 3D photoréaliste et peut être exportée sous forme de nuage de points ou de mesh.

Une étape intermédiaire essentielle n’a pas été évoquée ici : celle du recalage du modèle à une échelle réelle. En effet, les origines calculées et attribuées à chaque photo ne possèdent aucune réalité physique. Les distances sont exprimées de manière relative et nullement de manière absolue.

Exemple schématique :

“la distance séparant la photo A de la photo B est 2 fois plus longue que la distance la séparant de la photo C”.

Pour passer le modèle dans une matrice tridimensionnelle réelle dont les distances physiques sont exprimées de manière absolue, il est nécessaire d’ajouter des “points de calage”. Selon les logiciels, l’ajout de points de calage peut être réalisé avant ou après la reconstruction du modèle 3D.

Ces points de calage peuvent être matérialisés sous forme de cibles, de sphères ou de n’importe quel point facilement reconnaissable dans la scène pour lequel nous maîtrisons des coordonnées exprimées dans un système de projection préalablement défini.

L’intérêt est de maîtriser les coordonnées X, Y et Z de chaque cible afin que le modèle 3D soit mis à l’échelle mais également tourné sur l’ensemble des axes afin de rétablir une horizontalité correcte. Dans l’absolu, il suffirait d’une seule distance calculée entre deux points pour mettre le modèle à l’échelle, mais le problème de se baser uniquement sur des distances et non de points définis par des coordonnées provient justement du non rétablissement de l’inclinaison de la scène.

La mission de numérisation par photogrammétrie requiert donc l’intervention d’un géomètre ou à défaut la possession d’un matériel de géolocalisation haute précision travaillant en trois dimensions. Nous parlions précédemment de la nécessité de placer des cibles et de recueillir leurs coordonnées, vous comprenez désormais pourquoi.

Coût du matériel

Nous parlons ici de photogrammétrie terrestre sollicitant un appareil photo, un ordinateur de bureau, ainsi qu’un logiciel de photogrammétrie. Si les coûts présentés ici ne sauraient être garantis du fait des évolutions du marché, il est important pour vous d’avoir un ordre de grandeur de l'investissement que cela représente.

Pour l’appareil photo, nous pourrions vous recommander certains appareils photos ayant des capteurs atteignant les 400 megapixels, mais leur prix est est exorbitant.

[qodef_blockquote text="Pour débuter, considérez que vous arriverez à trouver des appareils photo de bon niveau entre 500 et 1 500 €." title_tag="p" width=""]

Concernant l’ordinateur, évitez de vous orienter vers des matériels portables, votre machine devra être facilement évolutive au gré de vos futurs besoins en ressources des logiciels. Entre une carte mère de haute performance, un processeur haut de gamme et une carte graphique professionnelle, considérez que votre ordinateur de calcul coûtera entre 4 000 et 10 000 €.

La partie logicielle est finalement la moins onéreuse, mais se chiffrera tout de même en plusieurs centaines d’euros pour les logiciels les plus communs.

Évidemment les coûts présentés ici seront très sujets à controverse.

[qodef_blockquote text="Il est en effet désormais possible de réaliser des modèles 3D par photogrammétrie en temps réel sur nos smartphones." title_tag="p" width=""]

C’est très ludique et cela démontre que le sujet de la numérisation 3D commence à trouver un écho à tous les niveaux, y compris pour le grand public.

Toutefois, ce type d’applications pour le monde de la construction ne sauraient être pertinentes en raison de la qualité nettement inférieure des capteurs photo, mais également du traitement photogrammétrique devant être réalisé à la volée sur un matériel ayant des ressources limitées, au détriment généralement de la précision des calculs.

Vous trouverez toujours quelqu’un pour vous dire qu’il ne sert à rien d’investir pour faire de la photogrammétrie, à vous de garder en tête à ce moment-là quels sont vos objectifs.

Génial, à livrer pour les urgences hospitalières universitaires en Belgique.

Concernant le matériel pour la puissance de calcul il peut être judicieux de s’orienter vers de la location de ressources en cloud pour effectuer des missions de photogrammétrie plutôt que d’acquérir du matériel onéreux.

Bonjour, Merci pour cet article très clair

il y a quelques temps j’avais tester le service de Cupix.com et j’avais trouvé trés impressionant, la visite virtuelle « à l’echelle » avec toute les cotes disponibles. Ceci a partir de photos 360°.

Mais ils ont changé leur offre commerciale, et je n’y trouve plus mon compte.

pouvez vous nous indiquer quelques site avec des sevices equivalents, permetant de prendre les dimension de l’intérieur d’un batiment SVP?

Merci ! et bravo !

En effet

Bonsoir,

Très intéressant, mais toujours la même erreur : la définition est le nombre de pixels d’un capteur, et le résolution, le nombre de pixels sur une distance donnée. Piège classique.