Les nuages de points et meshs, formats issus de la numérisation 3D, peuvent être obtenus par scanner 3D (lasergrammétrie) ou photogrammétrie.

Cette seconde technique est assez contre-intuitive : comment peut-on construire un modèle 3D à partir de photos ?

Voici comment fonctionne la photogrammétrie

La technique de la photogrammétrie peut sembler assez étonnante au premier abord car l’acquisition de données se fait à l’aide d’un simple capteur photo. Ceci revient à dire que quiconque possède un simple smartphone est en mesure de capturer la réalité en 3D, un pouvoir que beaucoup d’entre-nous n’ont pas envisagé !

[qodef_blockquote text="Un simple smartphone peut capturer une scène en 3D" title_tag="p" width=""]

Avez-vous remarqué que toutes les espèces vivantes dotées de la vue ont deux yeux (ou plus) ? Pourquoi pas n’avoir qu’un seul œil ? La réponse à cette question permet à elle seule d’expliquer le fonctionnement de la photogrammétrie : la stéréoscopie permet de voir les reliefs.

Essayez de jouer au tennis avec un oeil bandé et vous comprendrez vite à quel point vos deux yeux vous aident dans la compréhension de l’espace et dans l’anticipation des mouvements.

Notre cerveau est une formidable machine capable de modéliser en temps réel, et en trois dimensions, un espace sur la base de points de vue légèrement différents (nos deux yeux décalés) tout en s’aidant de la mémoire visuelle aux cours de nos déplacements pour multiplier les points de vue et augmenter la précision de l’image mentale que nous avons de la scène. Comprenez bien ce principe et vous aurez compris comment fonctionne la photogrammétrie !

[qodef_blockquote text="En termes technologiques, la photogrammétrie désigne la technique utilisée a posteriori d’une prise de vue permettant la modélisation numérique 3D d’un objet." title_tag="p" width=""]

Cette méthode est ancienne et se fonde sur le principe de corrélation d’images acquises selon des points de vue différents qui permet la reconnaissance automatique de points homologues.

Ce travail, trop fastidieux pour être raisonnablement réalisé par un humain à grande échelle, nécessite une puissance de calcul informatique considérable. Il est donc assez logique que les applications professionnelles ne se démocratisent que depuis quelques années, les supercalculateurs anciennement dédiés à ce genre d’opérations étant bien moins adaptés que les ordinateurs de bureaux modernes intégrant désormais la puissance nécessaire.

La corrélation des images consiste en la reconnaissance automatique de pixels homologues sur une surface définie. Des algorithmes d’analyse d’images se substituent à la vision humaine en associant à tout point d’une image A un point homologue dans une image B. À ce stade et de manière algorithmique, l’ordinateur procède à une lecture stéréoscopique de la scène pour déterminer les positions relatives de chaque point. La multiplication du processus à un grand nombre de points de vue permet de fiabiliser les calculs de position de chaque pixel en divisant l’erreur tout en augmentant l’étendue de la modélisation 3D.

Une application grand public méconnue

La plupart d’entre nous avons déjà vu le résultat d’un travail de photogrammétrie sans le savoir : les villes en 3D dans Google Maps/Earth.

En effet, bien que Google ait cherché par le passé à faire modéliser les bâtiments par ses utilisateurs au travers du logiciel Sketchup, acheté en 2005, une stratégie plus pérenne et efficiente est désormais retenue et repose sur la photogrammétrie.

Des campagnes de survols par avion au cours desquelles des photographies angulaires sont prises, sont menées régulièrement par la société. La société procède par la suite à un travail de reconstruction photogrammétrique, puis de tuilage 3D des “meshs” générés afin de permettre leur diffusion streamée dans Google Maps / Google Earth.

La photogrammétrie présente plusieurs avantages dans une telle application :

- diminution du travail humain,

- amélioration du réalisme et de la précision,

- actualisation des modèles 3D (modification d’un ouvrage, démolition, aménagements…)

- automatisation du processus de reconstruction,

- création d’orthophotos plus précises, etc.

La méthode photogrammétrique n’a pas tardé à démontrer son efficacité dans le cas de cette application faite par Google : Sketchup a été revendu à Trimble, 7 ans après son acquisition par Google, qui n’a désormais plus aucun intérêt à faire porter la charge de la modélisation numérique 3D des territoires par les utilisateurs eux-mêmes.

Encore plus d'articles comme celui-ci ?

D’autres applications grand public sont également faites de la photogrammétrie sans que l’on ne le sache forcément. Au cinéma, les acteurs sont parfois numérisés en utilisant cette méthode pour laisser leur “clone numérique” prendre à leur place les risques d’incroyables cascades à couper le souffle (souvent elles-mêmes totalement virtuelles).

Les espaces et objets sont également numérisés pour les jeux vidéos, le niveau de performance actuel des cartes graphiques étant désormais suffisant pour les exploiter à des fins récréatives.

De manière indirecte, certaines répliques miniatures de monuments historiques ont été imprimées en 3D ou moulées sur la base d’un modèle virtuel 3D de l’ouvrage, lui aussi obtenu par photogrammétrie.

Les applications en réalité virtuelle, réalité augmentée, autres expériences immersives en tout genre, sont le nouvel eldorado de la photogrammétrie.

Méthodes d’acquisition

Nous avons vu que la photogrammétrie est une technique permettant de capturer la réalité pour en créer un modèle numérique réaliste sur la base de photographies.

L'acquisition peut se faire au cours de campagnes “terrestres” : prise de vue depuis le sol par un humain ou une machine muni(e) de capteurs photographiques. On procède également fréquemment à des prises de vue aériennes, depuis un avion, un drone, ou n’importe quel autre outil permettant de faire voler un capteur photographique. Finalement, les outils sont assez basiques.

[qodef_blockquote text="Le principal enjeu est de parvenir à photographier depuis un angle de vue pertinent dans un but de reconstruction photogrammétrique." title_tag="p" width=""]

La vidéo ci-dessous mérite d'être regardée en entière : elle explique parfaitement comment prendre des photos pour un calcul photogrammétrique.

https://www.youtube.com/watch?v=D7Torjkfec4

La qualité de la méthode d’acquisition porte donc plus sur la procédure de prise de vue que sur les outils eux-mêmes. En effet, rappelons que la photogrammétrie utilise le principe de la vision stéréoscopique pour interpréter les volumes sur le principe des yeux couplés à un cerveau. De la même manière que vous ne saurez jamais décrire ce qui est de l’autre côté d’un bâtiment, que vous voyez pour la première fois sans vous déplacer pour regarder, la photogrammétrie a besoin de disposer d’un maximum de points de vue différents pour “comprendre” une scène.

Ce point est extrêmement important à comprendre, aussi, il est utile de l’illustrer au travers d’un exemple.

L’objet que nous découvrons pour la première fois et que nous souhaitons numériser est un immeuble de logements. En regardant la première façade, grâce à vos deux yeux, vous voyez déjà certains volumes : le terrain situé devant vous est plus proche que la façade. Vous voyez également aisément que le local poubelles est situé à l’arrière de l’immeuble.

Pourtant, il vous reste trois façades d’immeuble à découvrir. En fermant les yeux lors des déplacements, vous vous rendez successivement face à chacune des autres façades pour les rouvrir, et regarder à nouveau la scène. Cet exercice permet à votre cerveau de bénéficier de huits vues différentes de l’immeuble : quatre façades multipliées par deux yeux. Vous avez déjà de quoi construire un modèle 3D mental de la scène.

[qodef_blockquote text="Mais au fait, avez-vous vu le chat allongé sur le balcon au quatrième étage ?" title_tag="p" width=""]

Non, pas plus que chacun des objets de faible hauteur posés sur les autres balcons, ceci en raison de la “zone occluse” par la sous-face du balcon lorsqu’on regarde la scène depuis le bas. Votre modèle 3D mental est donc incomplet, et vous devez donc trouver un moyen de voir la scène depuis le haut.

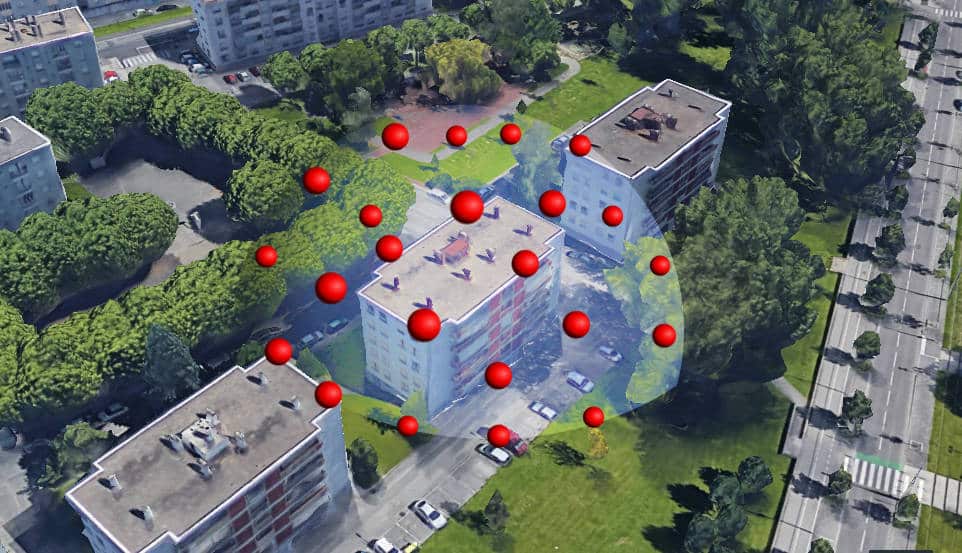

Vous choisissez donc de monter successivement dans les immeubles voisins pour prendre une photographie depuis différents étages. Un ami vous a également prêté un drone pour prendre une photographie située au “nadir” (point situé à la verticale de la scène).

Avez-vous remarqué les positions de vos prises de vue ? Vous avez décrit une sorte d’enveloppe autour de la scène. Cette méthode illustre schématiquement comment procéder à une campagne photogrammétrique réussie. Il est conseillé de toujours imaginer la scène comme un cube que vous devez englober dans une sphère de points correspondant aux positions des capteurs photo.

[qodef_blockquote text="Un moyen de numériser efficacement un espace est de ne jamais l’avoir vu au préalable, et de se mettre en tête qu’un trésor est caché dans un coin, et qu’il devra être trouvé au terme de la mission." title_tag="p" width=""]

Imaginer ce scénario conduit à considérer l’intégralité de la scène en se focalisant sur les “zones d’ombre” que nous n’avons encore pas explorées.

Importance du capteur photographique

Si la position des prises de vue revêt une importance capitale pour réduire les zones occluses et améliorer le réalisme du modèle, la résolution joue quant à elle, un rôle majeur sur la précision. Entendons bien ces deux notions.

Une scène numérisée en trois dimensions peut manquer de précision pour deux raisons :

- manque d’informations dans une zone,

- manque de points sur les images.

La position des prises de vue influe sur l’exhaustivité du modèle, c’est-à-dire sur la densité d’information dans une zone, alors que la résolution va influer sur la précision locale des données recueillies par chaque photo. Si vous portez des lunettes, imaginez-vous en train de visiter un bien immobilier :

- avec vos lunettes (meilleure résolution) mais en oubliant de visiter une pièce (exhaustivité réduite) : votre modèle 3D mental est précis mais incomplet;

- sans vos lunettes (mauvaise résolution) mais en visitant toutes les pièces (exhaustivité accrue) : votre modèle 3D mental est complet mais imprécis.

Vous comprendrez aisément que l’idéal reste de visiter toutes les pièces avec vos lunettes !

Ajoutons une troisième variable : la lumière. Conclure qu’il est impossible d’avoir une bonne image 3D du bien immobilier en le visitant volets fermés et toutes lumières éteintes revient à enfoncer des portes ouvertes, nous allons donc approfondir l’analyse. En fait, la lumière joue un rôle beaucoup plus insidieux, basé sur un phénomène moins facilement perçu par l’œil humain que par les capteurs photographiques. Il s’agit du phénomène de sous/sur exposition des images à fort contraste de luminosité.

Photographiez une roche blanche à midi en plein été un jour de beau temps, ainsi que son ombre, et vous constaterez que l’image est :

- soit “brûlée” sur les zones claires,

- soit “bouchée” sur les zones sombres.

Ces deux termes généralement employés par les photographes désignent une même réalité : une perte d’informations causée par une exposition trop contrastée, ou un appareil photo mal réglé. Pour cette raison, les photographes préfèrent généralement faire des photos portraits en extérieur les “jours blancs”, c’est-à-dire les jours où un voile nuageux peu épais rend la lumière plus diffuse, à l’image d’un néon qui éclaire sur toute sa longueur plutôt qu’un spot provenant d’un point unique. Les ombres sont ainsi nettement réduites, et le contraste ambiant permet d’unifier la précision. De la même manière, une campagne photogrammétrique gagnera en qualité grâce à ces facteurs.

[qodef_blockquote text="La qualité même de la photographie, que ce soit sa résolution ou son exposition, influe directement sur la précision du modèle 3D." title_tag="p" width=""]

Certaines techniques peuvent être employées pour améliorer cette qualité. C’est le cas par exemple de la technique HDR (Hight Dynamic Range) qui permet d'homogénéiser la luminosité d’une scène, en combinant plusieurs photographiques prises du même point de vue, avec une exposition différente. Les détails apparaissent ainsi dans les zones claires et sombres simultanément.

Cette technique est efficace mais complexe à mettre en oeuvre. En effet, la combinaison des photos nécessite que la scène soit rigoureusement identique : même position de capteur (trépied photo) et même scène (prise de vue rapprochée temporellement).

De ce fait, un traitement HDR sur la base de photos prises par un drone n’est pas envisageable, sauf si cette dernière était réalisée à la volée par l’appareil lui-même dans un intervalle de temps très court rendant les mouvements de l’appareil négligeables.

Les photos au format RAW sont une méthode plus simple à employer. Contrairement au format JPG habituellement employé qui compresse les données au même titre qu’un MP3 compresse la musique, le format RAW préserve l’intégralité des données recueillies par l’appareil photo. Bien que la qualité d’une photographique découle essentiellement des réglages mécaniques de temps d’ouverture, de sensibilité ISO et d’ouverture focale, il n’en demeure pas moins qu’une suppression de données jugées peu utiles est opérée lors d’une compression JPEG dans le but d’alléger les données. Ne pas recourir à cette compression permet donc d’espérer améliorer certains modèles.

Limites liées à la nature des surfaces

Malgré toutes les précautions prises lors de la prise de vue et en dépit des atouts de la photogrammétrie, la technique possède tout de même certaines faiblesses majeures. En effet, puisque tout repose sur l’image, l’apparence même des objets est alors garante de la bonne reconstruction tridimensionnelle. Or, certains objets peuvent avoir une apparence variable.

Le miroir de votre salle de bain n’en n’est-il pas le parfait exemple ? Quand vous le regardez il vous ressemble, mais il sait aussi ressembler à votre conjoint(e) lorsque cela s’avère nécessaire !

Repensez à l’exemple de l’immeuble que nous voulions numériser et appliquez-le à votre miroir. Lorsque vous le regarderez depuis votre premier point de vue vous verrez peut-être le reflet du sèche-serviette dans l’angle inférieur gauche, alors qu’en regardant depuis un autre point de vue, ce même reflet se sera déplacé au centre du miroir. Vous, humain éduqué, êtes en mesure, depuis votre tendre enfance, de comprendre ce phénomène et de détecter la position de ce miroir. Mais que voit un algorithme dans une telle configuration ? La même chose qu’un bébé qui découvre son reflet dans un miroir : un autre sujet !

[qodef_blockquote text="Un miroir produit une symétrie de la scène de telle manière qu’une reconstruction photogrammétrique aboutira à une réplication symétrique des éléments reflétés à l’arrière du miroir." title_tag="p" width=""]

Cette limite est également applicable aux scanners laser 3D LiDAR.

Les reflets engendrent donc une mauvaise interprétation des données et conduisent à une reconstruction 3D erronée. Cette thématique amène à découvrir deux notions importantes en capture de réalité : la réflectance et la réflexion.

La réflectance

Egalement nommée facteur de réflexion, est la proportion de lumière réfléchie par la surface d'un matériau. Elle est définie comme le rapport entre le flux lumineux réfléchi et le flux lumineux incident.

La réflexion

Elle est le brusque changement de direction d'une onde à l'interface de deux milieux.

En optique, on distingue la réflexion spéculaire de la réflexion diffuse. La première s'opère sur des surfaces planes et permet une réflexion du faisceau lumineux dans une seule direction de l'espace suivant la loi de la réflexion, l'autre a lieu sur des surfaces rugueuses et réfléchit l'onde incidente dans toutes les directions de l'espace.

Illustrons ces notions avec l’exemple du miroir. En considérant que ce dernier est propre, la réflexion sur la fine couche de métal composant le miroir est presque totale. La réflectance est proche de 100%, ce qui signifie que la quasi-totalité de l’intensité lumineuse reçue par le miroir est restituée. Mais, au delà de la réflectance, c’est la nature même de la réflexion qui influe sur la qualité de la reconstruction photogrammétrique.

Dans le cas d’une réflexion spéculaire telle que pour un miroir, la photogrammétrie ne pourra pas fonctionner, le LiDAR non plus. En revanche, en cas de réflexion diffuse liée à la rugosité de la surface, les deux techniques sauront tirer leur épingle du jeu. Concernant la photogrammétrie ceci s’explique par l’élimination des images parasites que sont les reflets alors que pour le LiDAR ceci s’expliquera par la présence partielle d’un retour d’intensité lumineuse.

Au-delà de ces notions physiques, l’important est de retenir l’image suivante : une table blanche mate pourra aisément être capturée en 3D par photogrammétrie, alors que blanche laquée, elle conduira à des aberrations de reconstruction. Lorsque c’est possible, les surfaces réfléchissantes sont parfois “matifiées” par pulvérisation d’une poudre pour éliminer les reflets. Bien qu’efficace, cette technique n’est pourtant pas toujours recommandable du fait de son caractère invasif parfois incompatible avec la scène à capturer (conservation de patrimoine par exemple).

Si les reflets posent problème, il en est de même pour les surfaces ayant une réflectance trop faible : les vitres ou l’eau par exemple, sans considération du reflet probable en surface selon les conditions d’éclairage. Voir à travers une vitre revient à ne pas voir le vitrage. Si vos yeux ne voient pas la vitre, la photogrammétrie ne le fera pas mieux que vous. A nouveau, opacifier la surface est un moyen de contourner cette limite.

Imagerie multispectrale et hyperspectrale

Ces notions seront abordées plus en détail dans les articles sur les applications LiDAR multi et hyperspectrales. Dans le cadre de la photogrammétrie, sachez qu’il existe des appareils capables de photographier des images dans des longueurs d’onde allant au-delà du spectre visible. Les caméras thermiques en sont une illustration assez commune.

La photogrammétrie n’est qu’une méthode permettant de reconstruire une scène en 3D sur la base d’images. Que ces dernières reflètent une réalité perceptible par un humain ou non, n’a que peu d’importance pour un algorithme de corrélation d’images. Il est donc tout à fait possible et parfois même préférable de réaliser des travaux photogrammétriques sur la base de capteurs hyperspectraux ou multispectraux.

Limites liées à la scène

Jusque là les limites de la photogrammétrie sont globalement acceptables pour la lasergrammétrie LiDAR. Toutefois, ces deux techniques diffèrent sur un point: les mouvements au sein de la scène.

La photogrammétrie repose sur la détection de points identiques entre différents angles de vue d’une même scène. Or, si des objets photographiés sont en mouvement, les pixels les représentant sur les photographies prises à des instants différents, ne correspondent à aucune réalité instantanée. Capturer une rue en 3D en utilisant la photogrammétrie est donc une tâche ardue conduisant nécessairement à un modèle tridimensionnel de piètre qualité.

La lasergrammétrie LiDAR quant à elle, présente l’avantage de récupérer directement la position d’un point au moment même de la captation. Si un objet est en mouvement, il sera ainsi capturé dans le nuage de points à sa position réelle au moment de l’envoi du signal laser. Certes, par la multiplication des stations de scanner laser 3D, ces objets en mouvement auront tendance à polluer le nuage de points, et rendront nécessaire le nettoyage de la scène, mais la reconstruction 3D sera tout de même possible et fiable contrairement à la photogrammétrie.

Très instructif, bravo!

Y a t’il pour un usage amateur un logiciel open source qui permette de faire du scanning photo?

Bien cordialement

Alain.

Merci. Je vous recommande de regarder du côté de Meshroom : https://alicevision.github.io/.

Le projet avance beaucoup ces derniers temps.

Cordialement.

Peut on établir le niveau de precision d’une mesure établit à partir de la photogrammetrie?

Cas concret:

Le positionnement d’une canalisation enterrée, peut il etre fait en photogrammetrie et répondre à l’arrete du 19/2/2012 qui demande une précision de 10 cm dans les 3 axes?

Merci

Cordialement